lw4 #2

@ -6,9 +6,9 @@

|

|||||||

## Лабораторные работы

|

## Лабораторные работы

|

||||||

|

|

||||||

1. [Знакомство с docker и docker-compose](labs/lab_1/README.md)

|

1. [Знакомство с docker и docker-compose](labs/lab_1/README.md)

|

||||||

2. TBA

|

2. [Разработка простейшего распределённого приложения](labs/lab_2/README.md)

|

||||||

3. TBA

|

3. [REST API, Gateway и синхронный обмен между микросервисами](labs/lab_3/README.md)

|

||||||

4. TBA

|

4. [Работа с брокером сообщений](labs/lab_4/README.md)

|

||||||

5. TBA

|

5. TBA

|

||||||

6. TBA

|

6. TBA

|

||||||

7. TBA

|

7. TBA

|

||||||

|

|||||||

113

labs/lab_2/README.md

Normal file

@ -0,0 +1,113 @@

|

|||||||

|

# Лабораторная работа №2 - Разработка простейшего распределённого приложения

|

||||||

|

|

||||||

|

**Цель**: изучение техники создания простого распределённого приложения.

|

||||||

|

|

||||||

|

**Задачи**:

|

||||||

|

|

||||||

|

1. **Согласно вашему варианту** разработать два приложения такие, что результат первого является исходными данными для второго.

|

||||||

|

2. Изучить файлы сборки образов docker и разработать их для созданных приложений.

|

||||||

|

3. Собрать файл `docker-compose.yml` для запуска приложений.

|

||||||

|

Разобраться с монтированием каталогов из хост-системы.

|

||||||

|

4. Правильно закоммитить результат без лишних файлов.

|

||||||

|

5. Оформить pull request по правилам и отправить его на проверку.

|

||||||

|

|

||||||

|

## Разработка двух приложений

|

||||||

|

|

||||||

|

Необходимо разработать 2 приложения согласно варианту.

|

||||||

|

Описание поиска своего варианта расположено ниже.

|

||||||

|

|

||||||

|

Общее для всех вариантов:

|

||||||

|

|

||||||

|

* Язык разработки приложений — любой.

|

||||||

|

* Содержимое исходных файлов - целые числа.

|

||||||

|

* Результат выполнения программы 2 необходимо дополнительно вывести на экран.

|

||||||

|

|

||||||

|

> Автор советует использовать dotnet, java, go или python.

|

||||||

|

|

||||||

|

Каждая программа должна лежать в отдельной подпапке в репозитории, например: `tasks/moiseev-vv/lab_2/worker-1` и `tasks/moiseev-vv/lab_2/worker-2`.

|

||||||

|

|

||||||

|

[Пример от автора](../../tasks/moiseev-vv/lab_2/).

|

||||||

|

|

||||||

|

## Добавление файлов сборки `Dockerfile`

|

||||||

|

|

||||||

|

В каталоге с каждым приложением необходимо создать файл `Dockerfile`, где будут расположены инструкции по сборке образа с вашими приложениями.

|

||||||

|

|

||||||

|

> Для многих языков программирования шаблоны `Dockerfile` можно найти в Интернете.

|

||||||

|

|

||||||

|

В рамках задания необходимо расписать, за что отвечает каждая значимая строка в `Dockerfile`.

|

||||||

|

Хотя бы одном.

|

||||||

|

|

||||||

|

Если у вас используется multi-stage build (как в примере выше, где в одном `Dockerfile` несколько конструкций `FROM`), необходимо расписать, зачем.

|

||||||

|

|

||||||

|

## Формирование файла `docker-compose.yml`

|

||||||

|

|

||||||

|

Необходимо в каталоге с вашей работой создать файл `docker-compose.yml`, чтобы можно было собрать и запустить программы следующей командой:

|

||||||

|

|

||||||

|

```

|

||||||

|

distributed-computing\tasks\moiseev-vv\lab_2$ docker compose up --build

|

||||||

|

```

|

||||||

|

|

||||||

|

> До `$` - каталог относительно корня репозитория, чтобы понять, откуда запускается `docker compose`.

|

||||||

|

|

||||||

|

Необходимо, чтобы в файле было:

|

||||||

|

|

||||||

|

1. Два сервиса.

|

||||||

|

Каждый соответствует вашим программам.

|

||||||

|

2. Объявлена директива `build` для каждого сервиса.

|

||||||

|

3. Была работа с монтированием папок.

|

||||||

|

4. Были описаны зависимости одного сервиса от другого.

|

||||||

|

|

||||||

|

## Оформление отчёта

|

||||||

|

|

||||||

|

Правила именования папки с отчётом и исходными текстами - `/tasks/фамилия-инициалы/lab_номер`, например, `/tasks/moiseev-vv/lab_2`.

|

||||||

|

|

||||||

|

[Пример отчёта и всего остального](../../tasks/moiseev-vv/lab_2/README.md).

|

||||||

|

|

||||||

|

## Коммит результата

|

||||||

|

|

||||||

|

Перед началом работы над задачей необходимо актуализировать свой форк, выполненный в работе №1.

|

||||||

|

|

||||||

|

Как это сделать зависит от конкретного хранилища git-репозиториев.

|

||||||

|

|

||||||

|

> TODO: Так как всё-таки?!

|

||||||

|

|

||||||

|

Также необходимо не забыть добавить файл `.gitignore` в каталог с вашей работой.

|

||||||

|

Если вы этого не сделаете, на коммит "полезут" файлы сборки и прочие вещи, который быть в публичном репозитории не должны.

|

||||||

|

|

||||||

|

> Для `dotnet` файл `.gitignore` создаётся при помощи команды `dotnet new gitignore`.

|

||||||

|

|

||||||

|

Правила именования ветки: `фамилия-инициалы-lab-номер`, например, `moiseev-vv-lab-2`.

|

||||||

|

|

||||||

|

## Правила оформления pull request

|

||||||

|

|

||||||

|

Название pull request: `[Л/Р 2] ФАМИЛИЯ ИМЯ`, например, `[Л/Р 2] Моисеев Владислав`.

|

||||||

|

|

||||||

|

## Варианты

|

||||||

|

|

||||||

|

Расчёт варианта также представляет собой задачку:

|

||||||

|

|

||||||

|

1. Необходимо найти номер своей зачёткой книжки.

|

||||||

|

Пусть будет _20/614_.

|

||||||

|

2. Далее необходимо найти **остаток от деления номера на 7**.

|

||||||

|

Это будет вариант для программы 1.

|

||||||

|

В нашем примере это `614 : 7 = 87 и остаток` **5**.

|

||||||

|

3. Вариант для программы 2 - **остаток от деления номера зачётки на 5**

|

||||||

|

В нашем случае это `614 : 5 = 122 и остаток` **4**.

|

||||||

|

|

||||||

|

### Варианты программы 1:

|

||||||

|

|

||||||

|

0. Ищет в каталоге `/var/data` самый большой по объёму файл и перекладывает его в `/var/result/data.txt`.

|

||||||

|

1. Ищет в каталоге `/var/data` файл с наибольшим количеством строк и перекладывает его в `/var/result/data.txt`.

|

||||||

|

2. Формирует файл `/var/result/data.txt` из первых строк всех файлов каталога `/var/data`.

|

||||||

|

3. Формирует файл `/var/result/data.txt` так, что каждая строка файла - количество строк в файлах из каталога `/var/data`.

|

||||||

|

4. Формирует файл `/var/result/data.txt` так, что каждая строка файла - количество символов в именах файлов из каталога `/var/data`.

|

||||||

|

5. Ищет в каталоге `/var/data` файл с самым коротким названием и перекладывает его в `/var/result/data.txt`.

|

||||||

|

6. Берёт из каталога `/var/data` случайный файл и перекладывает его в `/var/result/data.txt`.

|

||||||

|

|

||||||

|

### Варианты программы 2:

|

||||||

|

|

||||||

|

0. Сохраняет произведение первого и последнего числа из файла `/var/data/data.txt` в `/var/result/result.txt`.

|

||||||

|

1. Ищет набольшее число из файла `/var/data/data.txt` и сохраняет его вторую степень в `/var/result/result.txt`.

|

||||||

|

2. Ищет наименьшее число из файла `/var/data/data.txt` и сохраняет его третью степень в `/var/result/result.txt`.

|

||||||

|

3. Ищет набольшее число из файла `/var/data/data.txt` и сохраняет количество таких чисел из последовательности в `/var/result/result.txt`.

|

||||||

|

4. Ищет наименьшее число из файла `/var/data/data.txt` и сохраняет количество таких чисел из последовательности в `/var/result/result.txt`.

|

||||||

129

labs/lab_3/README.md

Normal file

@ -0,0 +1,129 @@

|

|||||||

|

# Лабораторная работа №3 - REST API, Gateway и синхронный обмен между микросервисами

|

||||||

|

|

||||||

|

Цель: изучение шаблона проектирования gateway, построения синхронного обмена между микросервисами и архитектурного стиля RESTful API.

|

||||||

|

|

||||||

|

Задачи:

|

||||||

|

|

||||||

|

1. Создать 2 микросервиса, реализующих CRUD на связанных сущностях.

|

||||||

|

2. Реализовать механизм синхронного обмена сообщениями между микросервисами.

|

||||||

|

3. Реализовать шлюз на основе прозрачного прокси-сервера nginx.

|

||||||

|

|

||||||

|

## Создание микросервисов

|

||||||

|

|

||||||

|

Создать два микросервиса.

|

||||||

|

|

||||||

|

Каждый сервис реализует CRUD-операции: список записей, подробности конкретной записи, создание, удаление и изменение записи.

|

||||||

|

|

||||||

|

В качестве хранилища данных может выступать оперативная память приложения или база данных.

|

||||||

|

|

||||||

|

Сущности необходимо подобрать по следующим критериям:

|

||||||

|

|

||||||

|

1. Они должны быть связаны с предполагаемой темой диплома.

|

||||||

|

2. Они должны быть связаны как `1-ко-многим``.

|

||||||

|

|

||||||

|

> Например, одна сущность - книга в библиотеке, вторая - абонемент.

|

||||||

|

>

|

||||||

|

> Поля абонемента: УИД (уникальный идентификатор) абонемента, Номер, ФИО читателя, Дата выдачи.

|

||||||

|

> Поля книги: УИД книги, Автор, Название, Год издания, УИД абонемента, на котором сейчас находится книга.

|

||||||

|

|

||||||

|

Общение между сервисами должно происходить при помощи API, реализованного при помощи архитектурного стиля проектирования REST.

|

||||||

|

То есть необходимо реализовать следующие endpoints:

|

||||||

|

|

||||||

|

1. "GET /" - Получение списка записей.

|

||||||

|

Должен возвращать массив моделей.

|

||||||

|

2. "GET /{uuid}" - Получение подробностей записи по УИД (uuid).

|

||||||

|

Должен возвращать модель или ошибку 404.

|

||||||

|

3. "POST /" - Создание новой записи.

|

||||||

|

Принимает на вход данные. Должен возвращать модель из п.2.

|

||||||

|

4. "PUT /{uuid}" - Обновление записи по УИД.

|

||||||

|

Принимает на вход новые данные. Должен возвращать модель из п.2 или ошибку 404.

|

||||||

|

5. "DELETE /{uuid}" - Удаление записи по УИД.

|

||||||

|

Возвращает коды 200 при успехе и 404, если запись не найдена.

|

||||||

|

|

||||||

|

Пример модели абонемента для списка и подробностей:

|

||||||

|

|

||||||

|

```json

|

||||||

|

{

|

||||||

|

"uuid": "8f036445-a5bd-401c-926e-840f9de795cd",

|

||||||

|

"number": 135,

|

||||||

|

"fullName": "Иванов И.И.",

|

||||||

|

"issued": "2023-10-18T05:41:00Z"

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

Пример модели абонемента для создания или изменения:

|

||||||

|

|

||||||

|

```json

|

||||||

|

{

|

||||||

|

"number": 135,

|

||||||

|

"fullName": "Иванов И.И.",

|

||||||

|

"issued": "2023-10-18T05:41:00Z"

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

> Как видите, нет УИДа, т.к. он присваивается системой, и изменять мы его не можем.

|

||||||

|

|

||||||

|

Пример модели книги для списка:

|

||||||

|

|

||||||

|

```json

|

||||||

|

{

|

||||||

|

"uuid": "8740d660-b251-4272-8535-be7ec3748d4b",

|

||||||

|

"author": "J.K.R.",

|

||||||

|

"subject": "HP and PS",

|

||||||

|

"year": 1997,

|

||||||

|

"subscriptionUuid": "8f036445-a5bd-401c-926e-840f9de795cd"

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

Пример модели книги для подробностей:

|

||||||

|

|

||||||

|

```json

|

||||||

|

{

|

||||||

|

"uuid": "8740d660-b251-4272-8535-be7ec3748d4b",

|

||||||

|

"author": "J.K.R.",

|

||||||

|

"subject": "HP and PS",

|

||||||

|

"year": 1997,

|

||||||

|

"subscriptionUuid": "8f036445-a5bd-401c-926e-840f9de795cd",

|

||||||

|

"subscriptionInfo": {

|

||||||

|

"number": 135,

|

||||||

|

"fullName": "Иванов И.И.",

|

||||||

|

"issued": "2023-10-18T05:41:00Z"

|

||||||

|

}

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

> Как видите, модель сильно богаче, чем при запросе списка.

|

||||||

|

>

|

||||||

|

> Как раз здесь и нужен синхронный обмен между сервисами.

|

||||||

|

|

||||||

|

Пример модели книги для создания или изменения:

|

||||||

|

|

||||||

|

```json

|

||||||

|

{

|

||||||

|

"author": "J.K.R.",

|

||||||

|

"subject": "HP and PS",

|

||||||

|

"year": 1997,

|

||||||

|

"subscriptionUuid": "8f036445-a5bd-401c-926e-840f9de795cd"

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

||||||

|

Как понять, куда обращаться микросервису книг для получения данных об абонементах?

|

||||||

|

Нам здесь поможет docker compose: код в "service" совпадает с хостом, куда следует обращаться.

|

||||||

|

|

||||||

|

## Реализация синхронного обмена

|

||||||

|

|

||||||

|

Как реализовать непосредственно работу с endpoints?

|

||||||

|

Например, использовать ASP.NET Core Minimal APIs.

|

||||||

|

[Небольшой пример, который это показывает](./example_1.cs).

|

||||||

|

|

||||||

|

Как вызвать синхронно данные с соседнего микросервиса?

|

||||||

|

Через HTTP-клиент!

|

||||||

|

[Небольшой пример, который это показывает](./example_2.cs).

|

||||||

|

|

||||||

|

## Реализация gateway при помощи nginx

|

||||||

|

|

||||||

|

Один сервер, несколько location, proxy_pass по хосту из docker-compose.yml, открытые порты наружу и... всё.

|

||||||

|

|

||||||

|

[Пример файла с настройкой nginx](./example_nginx.conf).

|

||||||

|

|

||||||

|

[Ещё один пример связи воркеров и nginx](../../tasks/moiseev-vv/lab_3).

|

||||||

76

labs/lab_3/example_1.cs

Normal file

@ -0,0 +1,76 @@

|

|||||||

|

List<TaskEntity> tasks = new()

|

||||||

|

{

|

||||||

|

new TaskEntity() { Uuid= Guid.NewGuid(), Subject = "Сдать третью лабу", IsCompleted = false },

|

||||||

|

};

|

||||||

|

|

||||||

|

var builder = WebApplication.CreateBuilder(args);

|

||||||

|

var app = builder.Build();

|

||||||

|

|

||||||

|

// Массив сущностей.

|

||||||

|

app.MapGet("/", () =>

|

||||||

|

{

|

||||||

|

return tasks.Select(t => new TaskEntityDto()

|

||||||

|

{

|

||||||

|

Uuid = t.Uuid,

|

||||||

|

Subject = t.Subject,

|

||||||

|

IsCompleted = t.IsCompleted,

|

||||||

|

});

|

||||||

|

});

|

||||||

|

|

||||||

|

// Подробности сущности.

|

||||||

|

app.MapGet("/{uuid}", (Guid uuid) =>

|

||||||

|

{

|

||||||

|

var task = tasks.FirstOrDefault(t => t.Uuid == uuid);

|

||||||

|

if (task == null)

|

||||||

|

return Results.NotFound();

|

||||||

|

return Results.Json(new TaskEntityDto()

|

||||||

|

{

|

||||||

|

Uuid = task.Uuid,

|

||||||

|

Subject = task.Subject,

|

||||||

|

IsCompleted = task.IsCompleted,

|

||||||

|

});

|

||||||

|

});

|

||||||

|

|

||||||

|

// Создание сущности.

|

||||||

|

app.MapPost("/", () => { throw new NotImplementedException(); });

|

||||||

|

|

||||||

|

// Изменение сущности.

|

||||||

|

app.MapPut("/{uuid}", () => { throw new NotImplementedException(); });

|

||||||

|

|

||||||

|

// Удаление сущности.

|

||||||

|

app.MapPost("/", () => { throw new NotImplementedException(); });

|

||||||

|

|

||||||

|

app.Run();

|

||||||

|

|

||||||

|

/// <summary>

|

||||||

|

/// Сама сущность.

|

||||||

|

/// </summary>

|

||||||

|

public class TaskEntity

|

||||||

|

{

|

||||||

|

public Guid Uuid { get; set; }

|

||||||

|

public string Subject { get; set; } = string.Empty;

|

||||||

|

public bool IsCompleted { get; set; }

|

||||||

|

}

|

||||||

|

|

||||||

|

/// <summary>

|

||||||

|

/// DTO-класс для описания сущности в API.

|

||||||

|

/// </summary>

|

||||||

|

public class TaskEntityDto : TaskEntity { }

|

||||||

|

|

||||||

|

/// <summary>

|

||||||

|

/// Запрос на создание сущности.

|

||||||

|

/// </summary>

|

||||||

|

public class TaskCreateRequest

|

||||||

|

{

|

||||||

|

public string Subject { get; set; } = string.Empty;

|

||||||

|

public bool IsCompleted { get; set; }

|

||||||

|

}

|

||||||

|

|

||||||

|

/// <summary>

|

||||||

|

/// Запрос на изменение сущности.

|

||||||

|

/// </summary>

|

||||||

|

public class TaskEditRequest

|

||||||

|

{

|

||||||

|

public string Subject { get; set; } = string.Empty;

|

||||||

|

public bool IsCompleted { get; set; }

|

||||||

|

}

|

||||||

26

labs/lab_3/example_2.cs

Normal file

@ -0,0 +1,26 @@

|

|||||||

|

var builder = WebApplication.CreateBuilder(args);

|

||||||

|

builder.Services.AddHttpClient(); // Добавляем библиотеку по работе с HTTP.

|

||||||

|

var app = builder.Build();

|

||||||

|

|

||||||

|

// Да, по заданию надо будет запрашивать метод /{uuid}. Тут запрашивается список.

|

||||||

|

app.MapGet("/", async (IHttpClientFactory httpClientFactory) =>

|

||||||

|

{

|

||||||

|

var remoteHost = "http://localhost:5158"; // Адрес, по которому развёрнут микросервис с задачами. В docker compose тут будет имя service.

|

||||||

|

var client = httpClientFactory.CreateClient();

|

||||||

|

var response = await client.GetFromJsonAsync<List<TaskEntityDto>>(remoteHost);

|

||||||

|

if (response == null)

|

||||||

|

return Results.BadRequest();

|

||||||

|

return Results.Ok($"Соседний микросервис отдал следующие задачи: {string.Join(", ", response.Select(i => i.Subject))}");

|

||||||

|

});

|

||||||

|

|

||||||

|

app.Run();

|

||||||

|

|

||||||

|

/// <summary>

|

||||||

|

/// DTO-класс для описания сущности из другого микросервиса.

|

||||||

|

/// </summary>

|

||||||

|

public class TaskEntityDto

|

||||||

|

{

|

||||||

|

public Guid Uuid { get; set; }

|

||||||

|

public string Subject { get; set; } = string.Empty;

|

||||||

|

public bool IsCompleted { get; set; }

|

||||||

|

}

|

||||||

21

labs/lab_3/example_nginx.conf

Normal file

@ -0,0 +1,21 @@

|

|||||||

|

server {

|

||||||

|

listen 80;

|

||||||

|

listen [::]:80;

|

||||||

|

server_name localhost;

|

||||||

|

|

||||||

|

location /test/ {

|

||||||

|

proxy_pass http://test:80/;

|

||||||

|

proxy_set_header Host $host;

|

||||||

|

proxy_set_header X-Real-IP $remote_addr;

|

||||||

|

proxy_set_header X-Forwarded-Proto $scheme;

|

||||||

|

proxy_set_header X-Forwarded-Prefix /test;

|

||||||

|

}

|

||||||

|

|

||||||

|

location /admin/ {

|

||||||

|

proxy_pass http://admin:80/;

|

||||||

|

proxy_set_header Host $host;

|

||||||

|

proxy_set_header X-Real-IP $remote_addr;

|

||||||

|

proxy_set_header X-Forwarded-Proto $scheme;

|

||||||

|

proxy_set_header X-Forwarded-Prefix /admin;

|

||||||

|

}

|

||||||

|

}

|

||||||

59

labs/lab_4/README.md

Normal file

@ -0,0 +1,59 @@

|

|||||||

|

# Лабораторная работа №4 - Работа с брокером сообщений

|

||||||

|

|

||||||

|

**Цель**: изучение проектирования приложений при помощи брокера сообщений.

|

||||||

|

|

||||||

|

**Задачи**:

|

||||||

|

|

||||||

|

1. Установить брокер сообщений RabbitMQ.

|

||||||

|

2. Пройти уроки 1, 2 и 3 из [RabbitMQ Tutorials](https://www.rabbitmq.com/getstarted.html) на любом языке программирования.

|

||||||

|

3. Продемонстрировать работу брокера сообщений.

|

||||||

|

|

||||||

|

## Установка брокера сообщений RabbitMQ

|

||||||

|

|

||||||

|

Можно не использовать Docker и использовать локальный ПК.

|

||||||

|

|

||||||

|

[Страница скачивания RabbitMQ с офф. сайта](https://www.rabbitmq.com/download.html).

|

||||||

|

|

||||||

|

[Страница релизов RabbitMQ](https://github.com/rabbitmq/rabbitmq-server/releases/), где есть бинарные установщики для всех современных платформ.

|

||||||

|

|

||||||

|

## Прохождение tutorial

|

||||||

|

|

||||||

|

Достаточно для каждого урока скриншота, где виден запуск одновременно `producer` и `consumer`, а также видно, что сообщения передаются.

|

||||||

|

|

||||||

|

## Разработка демонстрационных приложений

|

||||||

|

|

||||||

|

См. 3 главу tutorial.

|

||||||

|

|

||||||

|

Необходимо выбрать предметную область и разработать следующие приложения:

|

||||||

|

|

||||||

|

1. **Publisher**.

|

||||||

|

Программа, которая создаёт один **exchange** с типом _fanout_.

|

||||||

|

Программа должна раз в секунду генерировать сообщения в журнал событий согласно вашей предметной области.

|

||||||

|

Например, событие "пришёл заказ" или "сообщение от пользователя" или "необходимо создать отчёт".

|

||||||

|

2. **Consumer 1**.

|

||||||

|

Программа, которая создаёт под себя отдельную не анонимную (!) очередь (**queue**) (то есть имя queue НЕ пустая строка), создаёт **binding** на **exchange** и начинает принимать сообщения (_consume_).

|

||||||

|

Программа должна обрабатывать сообщения 2-3 секунды.

|

||||||

|

Можно реализовать через обычный _Thread.Sleep_ (для C#).

|

||||||

|

3. **Consumer 2**.

|

||||||

|

Аналогично _Consumer 1_, только сообщения необходимо обрабатывать моментально.

|

||||||

|

Только имя очереди должно отличаться от _Consumer 1_.

|

||||||

|

|

||||||

|

Далее необходимо собрать и запустить приложения одновременно по одному экземпляру.

|

||||||

|

|

||||||

|

Сделать в отчёте вывод о скорости обработки _consumer_-ами событий от _publisher_-а.

|

||||||

|

Для этого можно посмотреть заполненность созданных очередей.

|

||||||

|

А для этого можно использовать скриншот из **RabbitMQ Management UI**.

|

||||||

|

|

||||||

|

Запустить несколько копий _Consumer 1_.

|

||||||

|

Проверить заново заполненность очередей через _UI_.

|

||||||

|

|

||||||

|

## Правила оформления pull request

|

||||||

|

|

||||||

|

Код и отчёт со скриншотами необходимо положить в папку `tasks/фамилия-инициалы/lab_4`.

|

||||||

|

|

||||||

|

Не забудьте о файле `.gitignore`, чтобы не закоммитить ничего лишнего.

|

||||||

|

Для C#-проектов это, например, папки `bin` и `obj`.

|

||||||

|

|

||||||

|

Правила именования ветки: `фамилия-инициалы-lab-номер`, например, `moiseev-vv-lab-4`.

|

||||||

|

|

||||||

|

Название pull request: `[Л/Р 4] ФАМИЛИЯ ИМЯ`, например, `[Л/Р 4] Моисеев Владислав`.

|

||||||

149

tasks/Melnikov-ky/lab_1/README.md

Normal file

@ -0,0 +1,149 @@

|

|||||||

|

# Отчёт по лабораторной работе №1

|

||||||

|

|

||||||

|

Выполнил: студент гр. ИСЭбд-41, Мельников К.Ю.

|

||||||

|

|

||||||

|

## Разворачивание сервиса Gitea

|

||||||

|

|

||||||

|

Содержимое файла `docker-compose.yml` в папке Gitea:

|

||||||

|

```yaml

|

||||||

|

version: "3"

|

||||||

|

|

||||||

|

networks:

|

||||||

|

gitea:

|

||||||

|

external: false

|

||||||

|

# Контейнер Gitea

|

||||||

|

services: # Описание служб

|

||||||

|

server:

|

||||||

|

image: gitea/gitea:1.20.4 # Образ gitea

|

||||||

|

container_name: gitea # Наименование контейнера

|

||||||

|

environment: # Наши параметры

|

||||||

|

- USER_UID=1000

|

||||||

|

- USER_GID=1000

|

||||||

|

- GITEA__database__DB_TYPE=mysql

|

||||||

|

- GITEA__database__HOST=db:3306

|

||||||

|

- GITEA__database__NAME=gitea

|

||||||

|

- GITEA__database__USER=gitea

|

||||||

|

- GITEA__database__PASSWD=gitea

|

||||||

|

restart: always

|

||||||

|

networks: # Параметры сети

|

||||||

|

- gitea

|

||||||

|

volumes: # Каталоги для хранения данных контейнера

|

||||||

|

- ./gitea:/data

|

||||||

|

- /etc/timezone:/etc/timezone:ro

|

||||||

|

- /etc/localtime:/etc/localtime:ro

|

||||||

|

ports: # Порт локальный и внутри сети

|

||||||

|

- "3000:3000"

|

||||||

|

- "222:22"

|

||||||

|

depends_on:

|

||||||

|

- db

|

||||||

|

# База данных

|

||||||

|

db:

|

||||||

|

image: mysql:8 # Образ БД и версия

|

||||||

|

restart: always # Параметр перезапуска

|

||||||

|

environment: # Подключаем каталог с базой данных

|

||||||

|

- MYSQL_ROOT_PASSWORD=gitea

|

||||||

|

- MYSQL_USER=gitea

|

||||||

|

- MYSQL_PASSWORD=gitea

|

||||||

|

- MYSQL_DATABASE=gitea

|

||||||

|

networks: # Параметры сети

|

||||||

|

- gitea

|

||||||

|

volumes: # Том для хранения данных БД

|

||||||

|

- ./mysql:/var/lib/mysql

|

||||||

|

```

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

Открываем Docker Desktop и проверяем, что контейнер сервера БД и Gitea созданы и запущены:

|

||||||

|

|

||||||

|

|

||||||

|

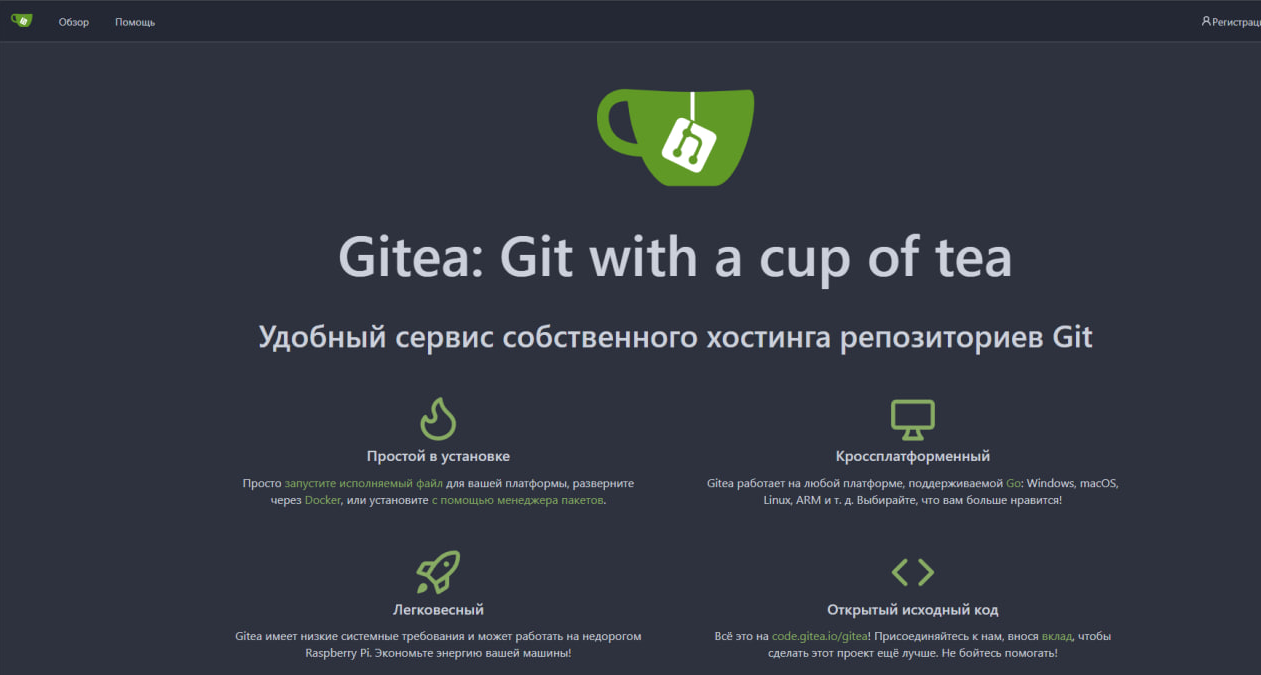

Переходим на http://localhost:222:

|

||||||

|

|

||||||

|

|

||||||

|

Регистрируемся и автоматически входим в учетную запись:

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## Разворачивание сервиса Wordpress

|

||||||

|

|

||||||

|

Также в файл `docker-compose.yml` в папке Wordpress прописываем следующий код:

|

||||||

|

|

||||||

|

```yaml

|

||||||

|

version: '3.1'

|

||||||

|

|

||||||

|

services:

|

||||||

|

# Контейнер Wordpress

|

||||||

|

wordpress:

|

||||||

|

image: wordpress # Образ

|

||||||

|

restart: always # Параметр перезапуска

|

||||||

|

ports: # На каком порте запускаем

|

||||||

|

- 7071:80

|

||||||

|

environment: # Настройки БД WordPress для подключения

|

||||||

|

WORDPRESS_DB_HOST: database # Имя хоста БД MySQL

|

||||||

|

WORDPRESS_DB_USER: user # Имя пользователя БД

|

||||||

|

WORDPRESS_DB_PASSWORD: password # Пароль пользователя БД

|

||||||

|

WORDPRESS_DB_NAME: name_database # Имя БД

|

||||||

|

volumes: # Каталог хранения файлов WordPress

|

||||||

|

- wordpress:/var/www/html

|

||||||

|

# Контейнер MySQL

|

||||||

|

database:

|

||||||

|

image: mysql:5.7 # Образ и его версия

|

||||||

|

restart: always # Параметр перезапуска

|

||||||

|

environment: # Настройки БД для подключения

|

||||||

|

MYSQL_DATABASE: name_database

|

||||||

|

MYSQL_USER: user

|

||||||

|

MYSQL_PASSWORD: password

|

||||||

|

MYSQL_RANDOM_ROOT_PASSWORD: '12345'

|

||||||

|

volumes: # Каталог хранения данных БД

|

||||||

|

- database:/var/lib/mysql

|

||||||

|

|

||||||

|

volumes:

|

||||||

|

wordpress:

|

||||||

|

database:

|

||||||

|

```

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

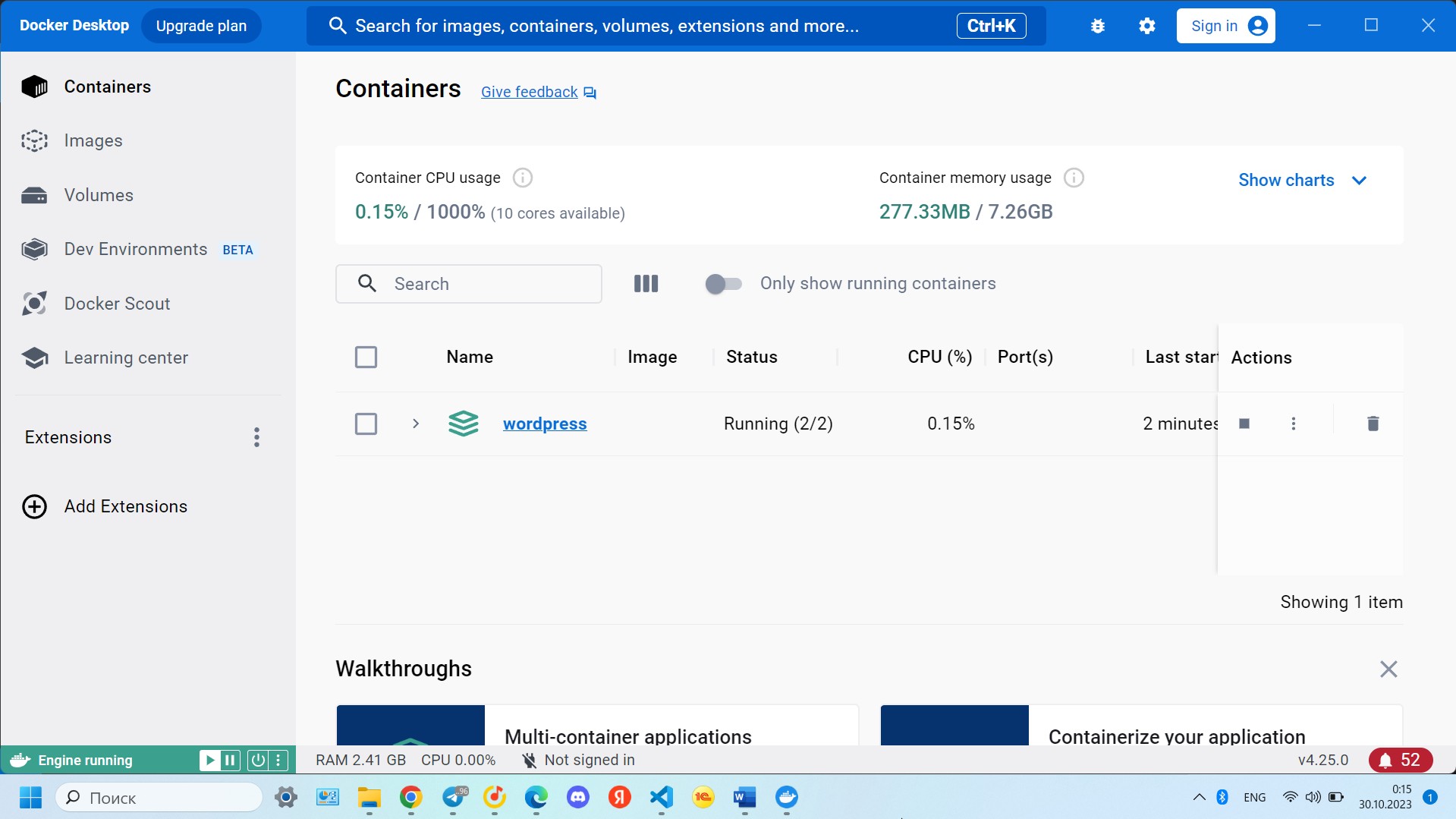

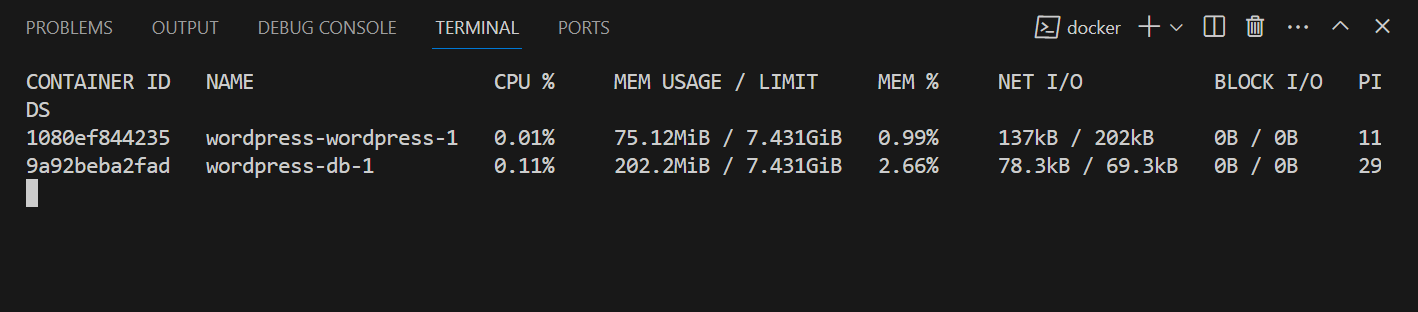

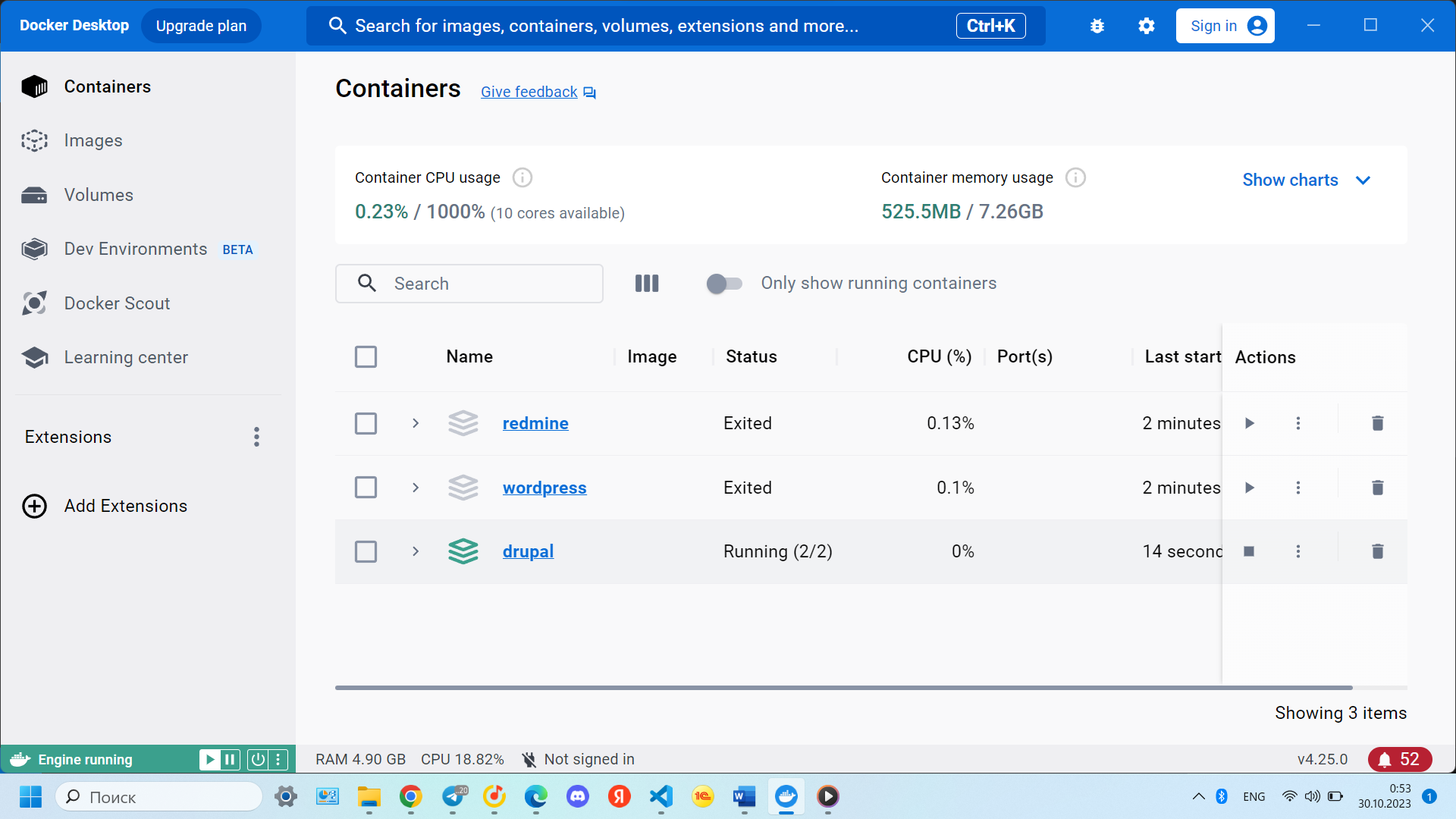

Открываем Docker Desktop и проверяем, что контейнер сервера БД и Wordpress созданы и запущены

|

||||||

|

|

||||||

|

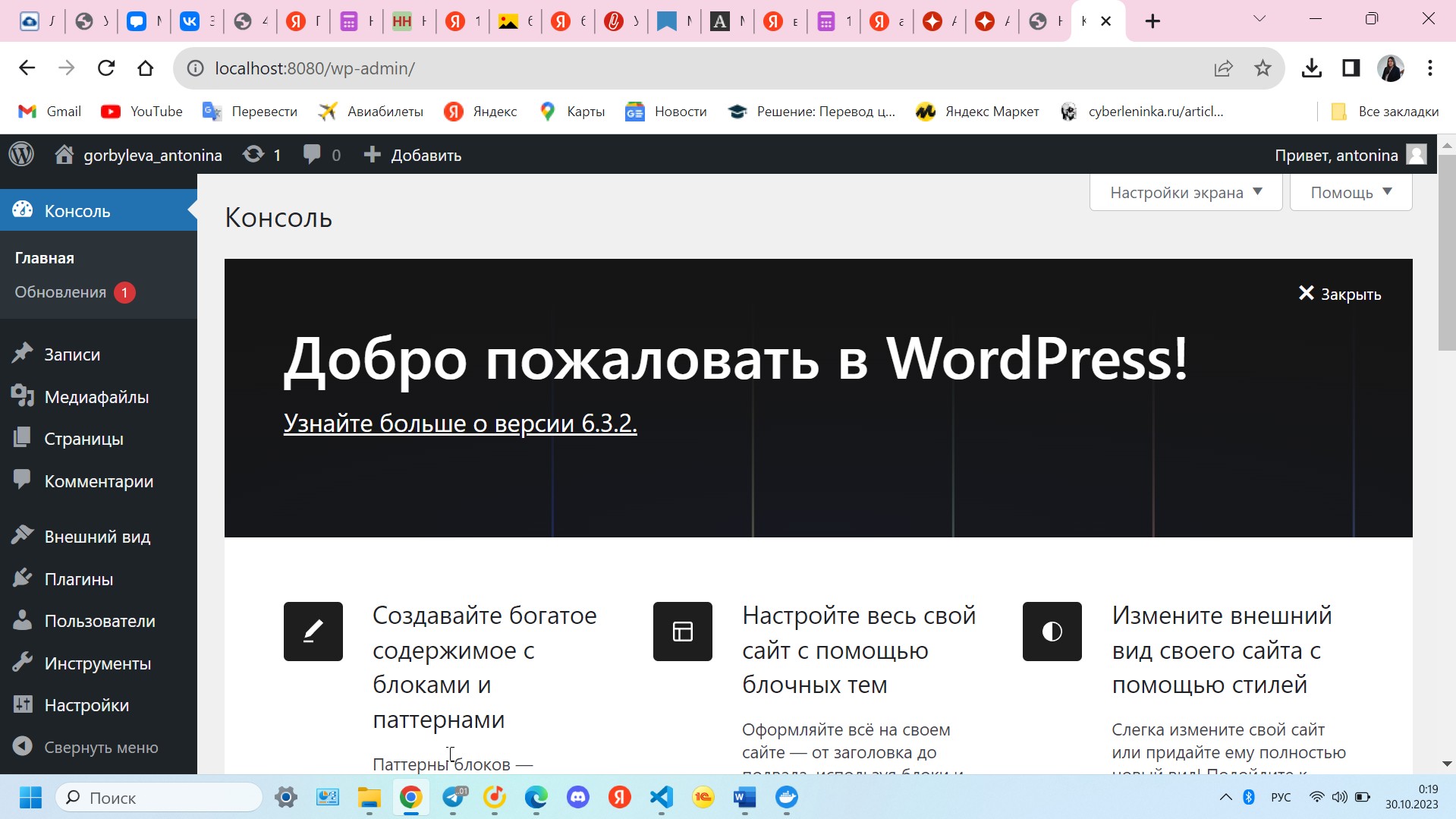

Устанавливаем Wordpress и проверяем, что все работает:

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## Разворачивание сервиса Redmine

|

||||||

|

|

||||||

|

Также в файл `docker-compose.yml` в папке Redmine прописываем код:

|

||||||

|

|

||||||

|

```yaml

|

||||||

|

version: '3.1'

|

||||||

|

|

||||||

|

services:

|

||||||

|

# Контейнер Redmine

|

||||||

|

redmine:

|

||||||

|

image: redmine # Образ контейнера

|

||||||

|

restart: always

|

||||||

|

ports: # На какой порт запускать

|

||||||

|

- 8080:3000

|

||||||

|

environment:

|

||||||

|

REDMINE_DB_MYSQL: db

|

||||||

|

REDMINE_DB_PASSWORD: example

|

||||||

|

REDMINE_SECRET_KEY_BASE: supersecretkey

|

||||||

|

# Контейнер БД MySQL

|

||||||

|

db:

|

||||||

|

image: mysql:5.7 # Образ БД и ее версия

|

||||||

|

restart: always

|

||||||

|

environment: # Название и пароль админа БД

|

||||||

|

MYSQL_ROOT_PASSWORD: example

|

||||||

|

MYSQL_DATABASE: redmine

|

||||||

|

```

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

Открываем Docker Desktop и проверяем, что контейнер сервера БД и Redmine созданы и запущены:

|

||||||

|

|

||||||

|

|

||||||

|

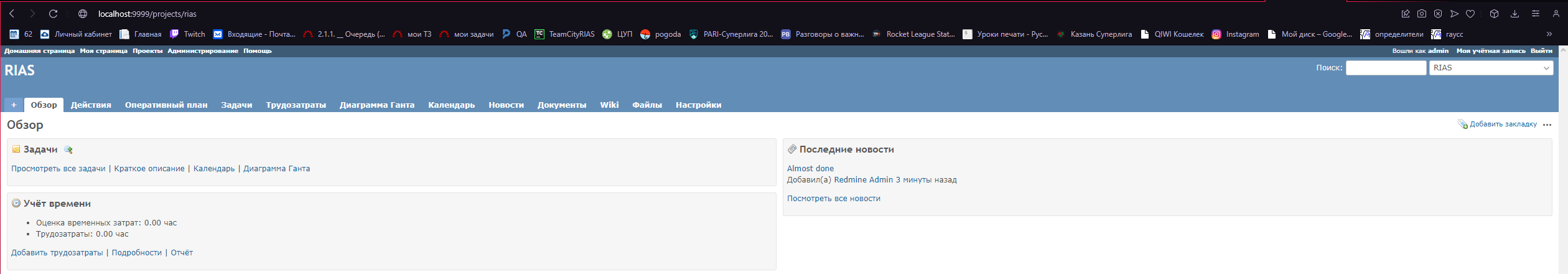

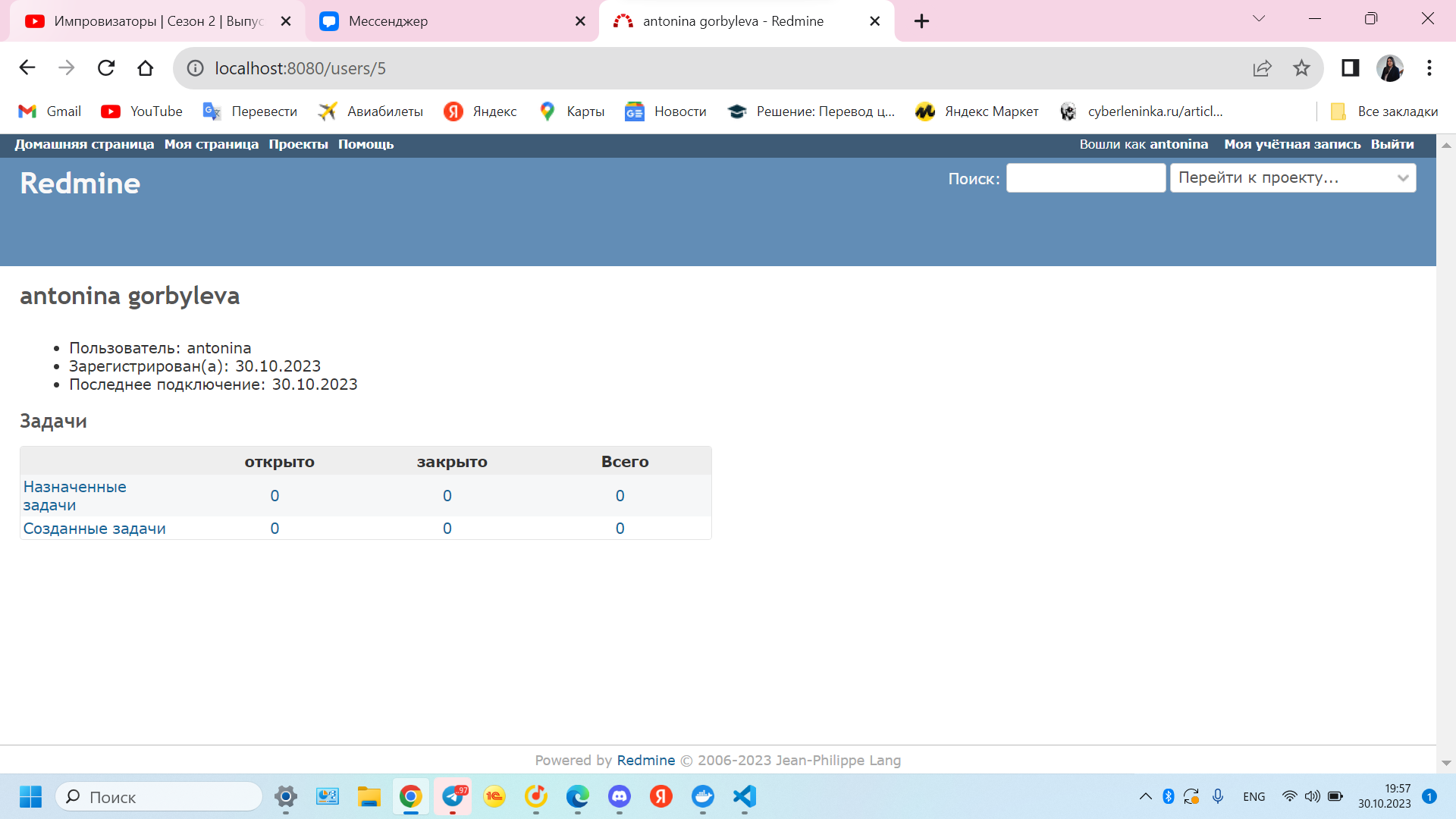

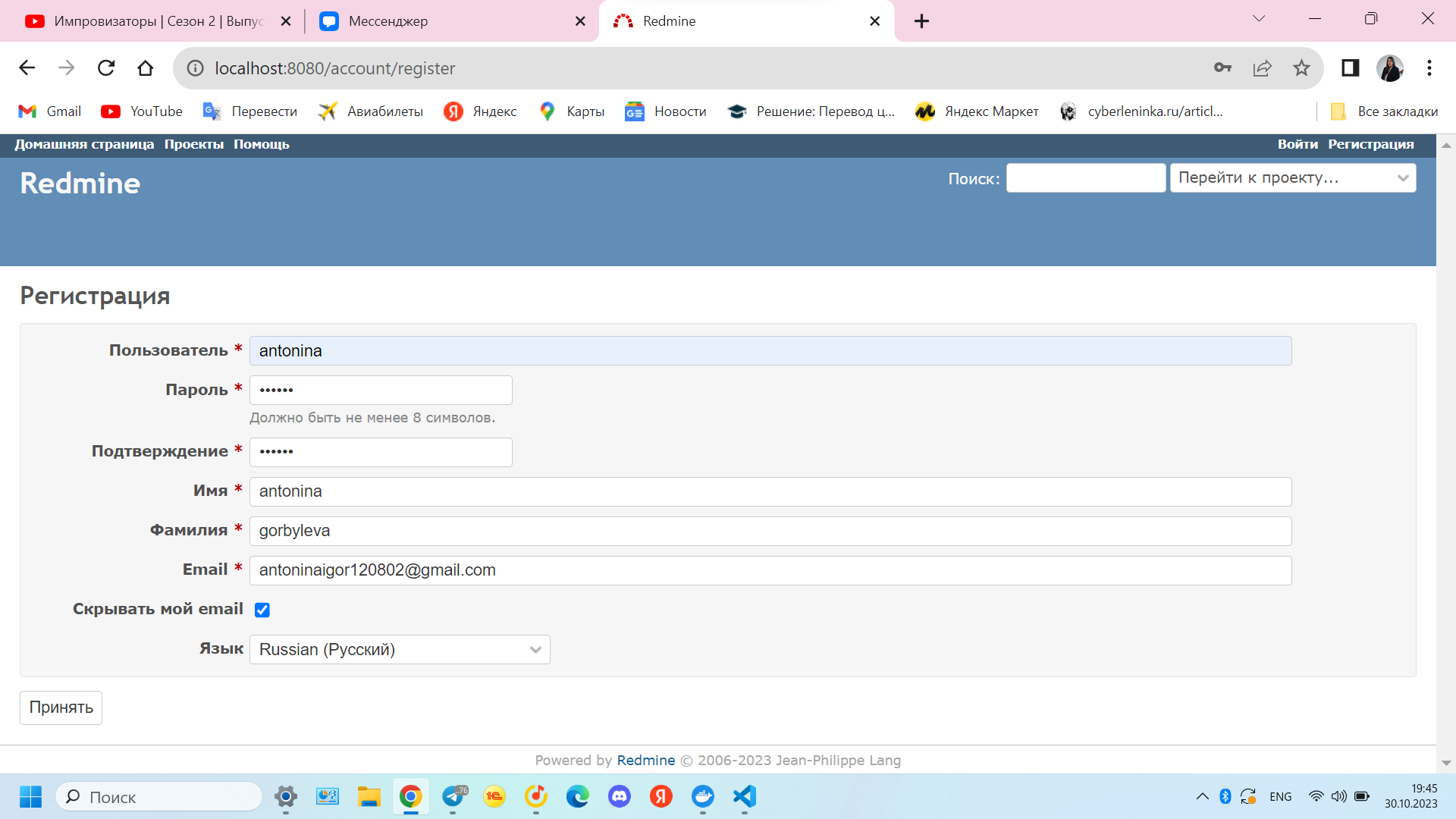

Переходим на http://localhost:8080:

|

||||||

|

|

||||||

|

|

||||||

|

Регистрируемся и проверяем, что все работает:

|

||||||

BIN

tasks/Melnikov-ky/lab_1/scrins/1.png

Normal file

|

After

(image error) Size: 37 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/10.png

Normal file

|

After

(image error) Size: 95 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/2.png

Normal file

|

After

(image error) Size: 91 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/3.png

Normal file

|

After

(image error) Size: 23 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/4.png

Normal file

|

After

(image error) Size: 173 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/5.png

Normal file

|

After

(image error) Size: 170 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/6.png

Normal file

|

After

(image error) Size: 24 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/7.png

Normal file

|

After

(image error) Size: 198 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/8.png

Normal file

|

After

(image error) Size: 17 KiB |

BIN

tasks/Melnikov-ky/lab_1/scrins/9.png

Normal file

|

After

(image error) Size: 47 KiB |

139

tasks/dunaev-oi/lab_1/README.md

Normal file

@ -0,0 +1,139 @@

|

|||||||

|

# Отчёт по лабораторной работе №1

|

||||||

|

|

||||||

|

Выполнил: студент гр. ИСЭбд-41, Дунаев О.И.

|

||||||

|

|

||||||

|

## Разворачивание сервиса Gitea

|

||||||

|

|

||||||

|

Содержимое файла `docker-compose.yml` в папке Gitea:

|

||||||

|

```yaml

|

||||||

|

version: "3"

|

||||||

|

|

||||||

|

networks:

|

||||||

|

gitea:

|

||||||

|

external: false

|

||||||

|

# Контейнер Gitea

|

||||||

|

services: # Описание служб

|

||||||

|

server:

|

||||||

|

image: gitea/gitea:1.20.4 # Образ gitea

|

||||||

|

container_name: gitea # Наименование контейнера

|

||||||

|

environment: # Наши параметры

|

||||||

|

- USER_UID=1000

|

||||||

|

- USER_GID=1000

|

||||||

|

- GITEA__database__DB_TYPE=mysql

|

||||||

|

- GITEA__database__HOST=db:3306

|

||||||

|

- GITEA__database__NAME=gitea

|

||||||

|

- GITEA__database__USER=gitea

|

||||||

|

- GITEA__database__PASSWD=gitea

|

||||||

|

restart: always

|

||||||

|

networks: # Параметры сети

|

||||||

|

- gitea

|

||||||

|

volumes: # Каталоги для хранения данных контейнера

|

||||||

|

- ./gitea:/data

|

||||||

|

- /etc/timezone:/etc/timezone:ro

|

||||||

|

- /etc/localtime:/etc/localtime:ro

|

||||||

|

ports: # Порт локальный и внутри сети

|

||||||

|

- "3000:3000"

|

||||||

|

- "222:22"

|

||||||

|

depends_on:

|

||||||

|

- db

|

||||||

|

# База данных

|

||||||

|

db:

|

||||||

|

image: mysql:8 # Образ БД и версия

|

||||||

|

restart: always # Параметр перезапуска

|

||||||

|

environment: # Подключаем каталог с базой данных

|

||||||

|

- MYSQL_ROOT_PASSWORD=gitea

|

||||||

|

- MYSQL_USER=gitea

|

||||||

|

- MYSQL_PASSWORD=gitea

|

||||||

|

- MYSQL_DATABASE=gitea

|

||||||

|

networks: # Параметры сети

|

||||||

|

- gitea

|

||||||

|

volumes: # Том для хранения данных БД

|

||||||

|

- ./mysql:/var/lib/mysql

|

||||||

|

```

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

Переходим на http://localhost:222:

|

||||||

|

|

||||||

|

|

||||||

|

Регистрируемся и автоматически входим в учетную запись:

|

||||||

|

|

||||||

|

|

||||||

|

## Разворачивание сервиса Wordpress

|

||||||

|

|

||||||

|

Также в файл `docker-compose.yml` в папке Wordpress прописываем следующий код:

|

||||||

|

|

||||||

|

```yaml

|

||||||

|

version: '3.1'

|

||||||

|

|

||||||

|

services:

|

||||||

|

# Контейнер Wordpress

|

||||||

|

wordpress:

|

||||||

|

image: wordpress # Образ

|

||||||

|

restart: always # Параметр перезапуска

|

||||||

|

ports: # На каком порте запускаем

|

||||||

|

- 7071:80

|

||||||

|

environment: # Настройки БД WordPress для подключения

|

||||||

|

WORDPRESS_DB_HOST: database # Имя хоста БД MySQL

|

||||||

|

WORDPRESS_DB_USER: user # Имя пользователя БД

|

||||||

|

WORDPRESS_DB_PASSWORD: password # Пароль пользователя БД

|

||||||

|

WORDPRESS_DB_NAME: name_database # Имя БД

|

||||||

|

volumes: # Каталог хранения файлов WordPress

|

||||||

|

- wordpress:/var/www/html

|

||||||

|

# Контейнер MySQL

|

||||||

|

database:

|

||||||

|

image: mysql:5.7 # Образ и его версия

|

||||||

|

restart: always # Параметр перезапуска

|

||||||

|

environment: # Настройки БД для подключения

|

||||||

|

MYSQL_DATABASE: name_database

|

||||||

|

MYSQL_USER: user

|

||||||

|

MYSQL_PASSWORD: password

|

||||||

|

MYSQL_RANDOM_ROOT_PASSWORD: '12345'

|

||||||

|

volumes: # Каталог хранения данных БД

|

||||||

|

- database:/var/lib/mysql

|

||||||

|

|

||||||

|

volumes:

|

||||||

|

wordpress:

|

||||||

|

database:

|

||||||

|

```

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

Открываем Docker Desktop и проверяем, что контейнер сервера БД и Wordpress созданы и запущены:

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## Разворачивание сервиса Redmine

|

||||||

|

|

||||||

|

Также в файл `docker-compose.yml` в папке Redmine прописываем код:

|

||||||

|

|

||||||

|

```yaml

|

||||||

|

version: '3.1'

|

||||||

|

|

||||||

|

services:

|

||||||

|

# Контейнер Redmine

|

||||||

|

redmine:

|

||||||

|

image: redmine # Образ контейнера

|

||||||

|

restart: always

|

||||||

|

ports: # На какой порт запускать

|

||||||

|

- 8080:3000

|

||||||

|

environment:

|

||||||

|

REDMINE_DB_MYSQL: db

|

||||||

|

REDMINE_DB_PASSWORD: example

|

||||||

|

REDMINE_SECRET_KEY_BASE: supersecretkey

|

||||||

|

# Контейнер БД MySQL

|

||||||

|

db:

|

||||||

|

image: mysql:5.7 # Образ БД и ее версия

|

||||||

|

restart: always

|

||||||

|

environment: # Название и пароль админа БД

|

||||||

|

MYSQL_ROOT_PASSWORD: example

|

||||||

|

MYSQL_DATABASE: redmine

|

||||||

|

```

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

Переходим на http://localhost:8080:

|

||||||

|

|

||||||

|

|

||||||

|

Регистрируемся и проверяем, что все работает:

|

||||||

|

|

||||||

BIN

tasks/dunaev-oi/lab_1/pic/1.png

Normal file

|

After

(image error) Size: 44 KiB |

BIN

tasks/dunaev-oi/lab_1/pic/2.png

Normal file

|

After

(image error) Size: 84 KiB |

BIN

tasks/dunaev-oi/lab_1/pic/3.png

Normal file

|

After

(image error) Size: 42 KiB |

BIN

tasks/dunaev-oi/lab_1/pic/4.png

Normal file

|

After

(image error) Size: 29 KiB |

BIN

tasks/dunaev-oi/lab_1/pic/5.png

Normal file

|

After

(image error) Size: 75 KiB |

BIN

tasks/dunaev-oi/lab_1/pic/6.png

Normal file

|

After

(image error) Size: 40 KiB |

BIN

tasks/dunaev-oi/lab_1/pic/7.png

Normal file

|

After

(image error) Size: 15 KiB |

BIN

tasks/dunaev-oi/lab_1/pic/8.png

Normal file

|

After

(image error) Size: 153 KiB |

157

tasks/fomichev-ai/lab_1/README.md

Normal file

@ -0,0 +1,157 @@

|

|||||||

|

# Отчёт по лабораторной работе №1

|

||||||

|

|

||||||

|

Выполнил: студент гр. ИСЭбд-41 Фомичев А.И.

|

||||||

|

|

||||||

|

## Разворачивание сервиса Redmine

|

||||||

|

|

||||||

|

Содержимое файла `docker-compose.yml` в папке Redmine:

|

||||||

|

|

||||||

|

```yaml

|

||||||

|

version: "3.8"

|

||||||

|

|

||||||

|

services: # Задаем сервисы.

|

||||||

|

db: # Сервис 1. База данных Postgres.

|

||||||

|

image: postgres:13.2-alpine # Образ БД.

|

||||||

|

restart: unless-stopped

|

||||||

|

environment: # Переменные окружения.

|

||||||

|

POSTGRES_PASSWORD: example # Пароль от postgres.

|

||||||

|

container_name: db_redmine # Название контейнера.

|

||||||

|

volumes: # Место хранения данных для БД.

|

||||||

|

- database:/var/lib/postgresql/data

|

||||||

|

redmine: # Сервис 2. Редмайн.

|

||||||

|

image: redmine:4.1-alpine # Образ.

|

||||||

|

environment: # Переменные окружения.

|

||||||

|

- REDMINE_DB_POSTGRES=db

|

||||||

|

- REDMINE_DB_PASSWORD=example

|

||||||

|

ports: # Прослушиваемые порты.

|

||||||

|

- 9999:3000

|

||||||

|

volumes: # Файлы редмайна.

|

||||||

|

- files:/usr/src/redmine/files

|

||||||

|

depends_on: # Зависимость от БД.

|

||||||

|

- db

|

||||||

|

|

||||||

|

volumes:

|

||||||

|

database:

|

||||||

|

files:

|

||||||

|

```

|

||||||

|

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

Смотрим в Docker Desktop, что контейнеры БД и сервиса Redmine запущены успешно.

|

||||||

|

|

||||||

|

|

||||||

|

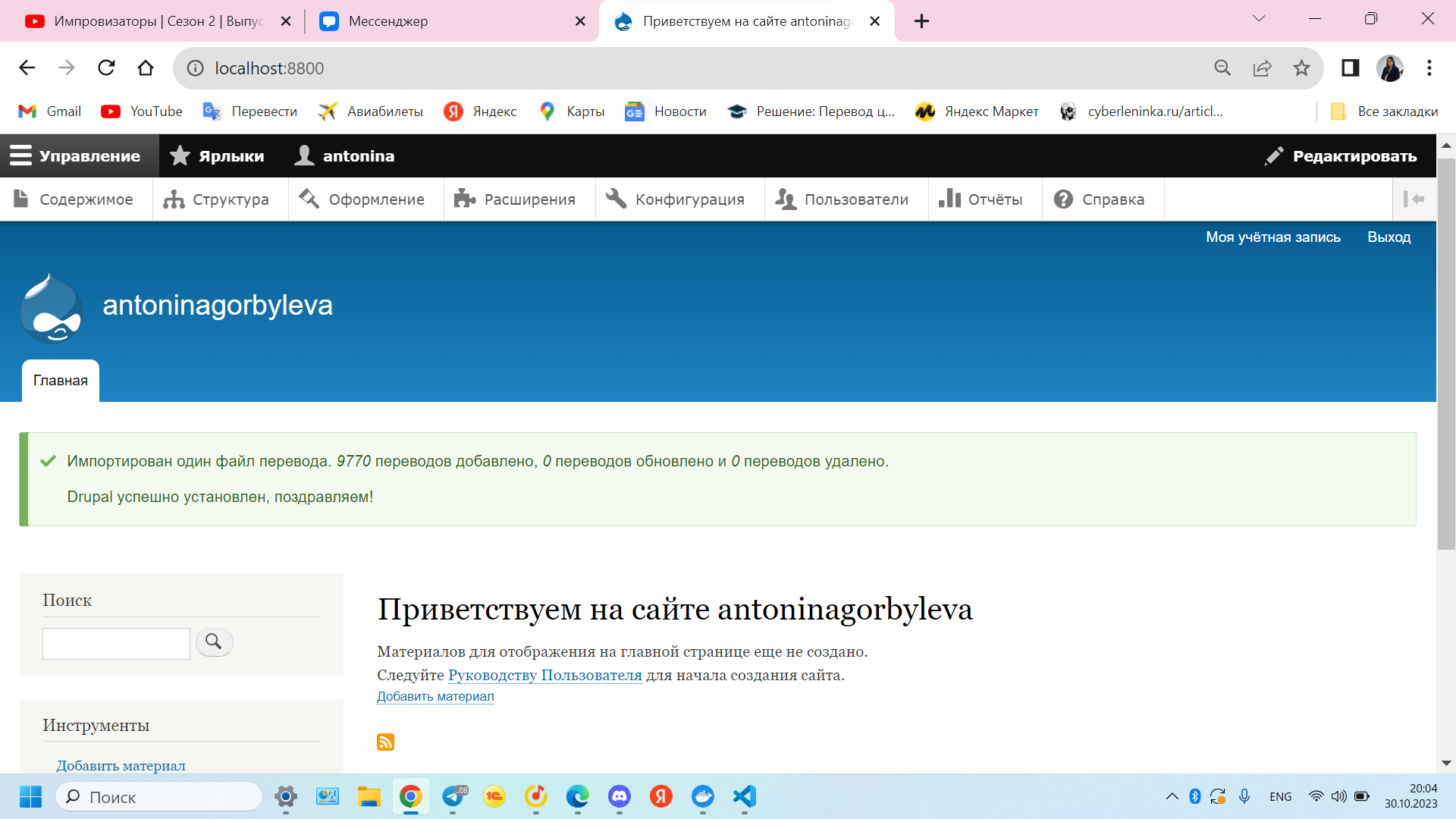

Переходим на http://localhost:9999 и авторизовываемся под администратором.

|

||||||

|

|

||||||

|

|

||||||

|

Создаем проект и некоторые данные.

|

||||||

|

|

||||||

|

|

||||||

|

Наблюдаем полностью рабочий сервис с БД.

|

||||||

|

|

||||||

|

## Разворачивание сервиса Wordpress

|

||||||

|

|

||||||

|

Также в файл `docker-compose.yml` в папке Wordpress прописываем следующий код:

|

||||||

|

|

||||||

|

```yaml

|

||||||

|

version: '3.1'

|

||||||

|

|

||||||

|

services:

|

||||||

|

wordpress:

|

||||||

|

image: wordpress

|

||||||

|

restart: always

|

||||||

|

ports:

|

||||||

|

- 8080:80

|

||||||

|

environment:

|

||||||

|

WORDPRESS_DB_HOST: db

|

||||||

|

WORDPRESS_DB_USER: test2

|

||||||

|

WORDPRESS_DB_PASSWORD: test123

|

||||||

|

WORDPRESS_DB_NAME: wordpressDB

|

||||||

|

volumes:

|

||||||

|

- wordpress:/var/www/html

|

||||||

|

|

||||||

|

db:

|

||||||

|

image: mysql:5.7

|

||||||

|

restart: always

|

||||||

|

environment:

|

||||||

|

MYSQL_DATABASE: wordpressDB

|

||||||

|

MYSQL_USER: test2

|

||||||

|

MYSQL_PASSWORD: test123

|

||||||

|

MYSQL_RANDOM_ROOT_PASSWORD: '1'

|

||||||

|

volumes:

|

||||||

|

- db:/var/lib/mysql

|

||||||

|

|

||||||

|

volumes:

|

||||||

|

wordpress:

|

||||||

|

db:

|

||||||

|

```

|

||||||

|

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

Смотрим в Docker Desktop, что контейнеры БД и сервиса Wordpress запущены успешно.

|

||||||

|

|

||||||

|

|

||||||

|

Переходим на http://localhost:8080, авторизовываемся под администратором и создаем наш сайт.

|

||||||

|

|

||||||

|

|

||||||

|

Сервис развернут успешно.

|

||||||

|

|

||||||

|

## Разворачивание сервиса Gitea

|

||||||

|

|

||||||

|

В файл `docker-compose.yml` прописываем следующий код:

|

||||||

|

|

||||||

|

```yaml

|

||||||

|

version: "3"

|

||||||

|

|

||||||

|

networks:

|

||||||

|

gitea:

|

||||||

|

external: false

|

||||||

|

services:

|

||||||

|

server:

|

||||||

|

image: gitea/gitea:1.20.4

|

||||||

|

container_name: gitea

|

||||||

|

environment:

|

||||||

|

- USER_UID=1000

|

||||||

|

- USER_GID=1000

|

||||||

|

- GITEA__database__DB_TYPE=mysql

|

||||||

|

- GITEA__database__HOST=db:3306

|

||||||

|

- GITEA__database__NAME=gitea

|

||||||

|

- GITEA__database__USER=gitea

|

||||||

|

- GITEA__database__PASSWD=gitea

|

||||||

|

restart: always

|

||||||

|

networks:

|

||||||

|

- gitea

|

||||||

|

volumes:

|

||||||

|

- ./gitea:/data

|

||||||

|

- /etc/timezone:/etc/timezone:ro

|

||||||

|

- /etc/localtime:/etc/localtime:ro

|

||||||

|

ports:

|

||||||

|

- "3000:3000"

|

||||||

|

- "222:22"

|

||||||

|

depends_on:

|

||||||

|

- db

|

||||||

|

db:

|

||||||

|

image: mysql:8

|

||||||

|

restart: always

|

||||||

|

environment:

|

||||||

|

- MYSQL_ROOT_PASSWORD=gitea

|

||||||

|

- MYSQL_USER=gitea

|

||||||

|

- MYSQL_PASSWORD=gitea

|

||||||

|

- MYSQL_DATABASE=gitea

|

||||||

|

networks:

|

||||||

|

- gitea

|

||||||

|

volumes:

|

||||||

|

- ./mysql:/var/lib/mysql

|

||||||

|

```

|

||||||

|

|

||||||

|

Далее в командной строке разворачиваем сервис командой `docker-compose up -d`:

|

||||||

|

|

||||||

|

|

||||||

|

Смотрим в Docker Desktop, что контейнеры БД и сервиса Wordpress запущены успешно.

|

||||||

|

|

||||||

|

|

||||||

|

Переходим на http://localhost:3000, авторизовываемся под администратором и создаем наш сайт.

|

||||||

|

|

||||||

|

|

||||||

|

Сервис развернут успешно.

|

||||||

BIN

tasks/fomichev-ai/lab_1/images/image1.PNG

Normal file

|

After

(image error) Size: 20 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image10.PNG

Normal file

|

After

(image error) Size: 14 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image2.PNG

Normal file

|

After

(image error) Size: 48 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image3.PNG

Normal file

|

After

(image error) Size: 81 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image4.PNG

Normal file

|

After

(image error) Size: 59 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image5.PNG

Normal file

|

After

(image error) Size: 23 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image6.PNG

Normal file

|

After

(image error) Size: 77 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image7.PNG

Normal file

|

After

(image error) Size: 204 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image8.PNG

Normal file

|

After

(image error) Size: 72 KiB |

BIN

tasks/fomichev-ai/lab_1/images/image9.png

Normal file

|

After

(image error) Size: 274 KiB |

2

tasks/fomichev-ai/lab_2/.dockerignore

Normal file

@ -0,0 +1,2 @@

|

|||||||

|

*/*/bin

|

||||||

|

*/*/obj

|

||||||

477

tasks/fomichev-ai/lab_2/.gitignore

vendored

Normal file

@ -0,0 +1,477 @@

|

|||||||

|

## Ignore Visual Studio temporary files, build results, and

|

||||||

|

## files generated by popular Visual Studio add-ons.

|

||||||

|

##

|

||||||

|

## Get latest from https://github.com/github/gitignore/blob/main/VisualStudio.gitignore

|

||||||

|

|

||||||

|

# User-specific files

|

||||||

|

*.rsuser

|

||||||

|

*.suo

|

||||||

|

*.user

|

||||||

|

*.userosscache

|

||||||

|

*.sln.docstates

|

||||||

|

|

||||||

|

# User-specific files (MonoDevelop/Xamarin Studio)

|

||||||

|

*.userprefs

|

||||||

|

|

||||||

|

# Mono auto generated files

|

||||||

|

mono_crash.*

|

||||||

|

|

||||||

|

# Build results

|

||||||

|

[Dd]ebug/

|

||||||

|

[Dd]ebugPublic/

|

||||||

|

[Rr]elease/

|

||||||

|

[Rr]eleases/

|

||||||

|

x64/

|

||||||

|

x86/

|

||||||

|

[Ww][Ii][Nn]32/

|

||||||

|

[Aa][Rr][Mm]/

|

||||||

|

[Aa][Rr][Mm]64/

|

||||||

|

bld/

|

||||||

|

[Bb]in/

|

||||||

|

[Oo]bj/

|

||||||

|

[Ll]og/

|

||||||

|

[Ll]ogs/

|

||||||

|

|

||||||

|

# Visual Studio 2015/2017 cache/options directory

|

||||||

|

.vs/

|

||||||

|

# Uncomment if you have tasks that create the project's static files in wwwroot

|

||||||

|

#wwwroot/

|

||||||

|

|

||||||

|

# Visual Studio 2017 auto generated files

|

||||||

|

Generated\ Files/

|

||||||

|

|

||||||

|

# MSTest test Results

|

||||||

|

[Tt]est[Rr]esult*/

|

||||||

|

[Bb]uild[Ll]og.*

|

||||||

|

|

||||||

|

# NUnit

|

||||||

|

*.VisualState.xml

|

||||||

|

TestResult.xml

|

||||||

|

nunit-*.xml

|

||||||

|

|

||||||

|

# Build Results of an ATL Project

|

||||||

|

[Dd]ebugPS/

|

||||||

|

[Rr]eleasePS/

|

||||||

|

dlldata.c

|

||||||

|

|

||||||

|

# Benchmark Results

|

||||||

|

BenchmarkDotNet.Artifacts/

|

||||||

|

|

||||||

|

# .NET

|

||||||

|

project.lock.json

|

||||||

|

project.fragment.lock.json

|

||||||

|

artifacts/

|

||||||

|

|

||||||

|

# Tye

|

||||||

|

.tye/

|

||||||

|

|

||||||

|

# ASP.NET Scaffolding

|

||||||

|

ScaffoldingReadMe.txt

|

||||||

|

|

||||||

|

# StyleCop

|

||||||

|

StyleCopReport.xml

|

||||||

|

|

||||||

|

# Files built by Visual Studio

|

||||||

|

*_i.c

|

||||||

|

*_p.c

|

||||||

|

*_h.h

|

||||||

|

*.ilk

|

||||||

|

*.meta

|

||||||

|

*.obj

|

||||||

|

*.iobj

|

||||||

|

*.pch

|

||||||

|

*.pdb

|

||||||

|

*.ipdb

|

||||||

|

*.pgc

|

||||||

|

*.pgd

|

||||||

|

*.rsp

|

||||||

|

*.sbr

|

||||||

|

*.tlb

|

||||||

|

*.tli

|

||||||

|

*.tlh

|

||||||

|

*.tmp

|

||||||

|

*.tmp_proj

|

||||||

|

*_wpftmp.csproj

|

||||||

|

*.log

|

||||||

|

*.tlog

|

||||||

|

*.vspscc

|

||||||

|

*.vssscc

|

||||||

|

.builds

|

||||||

|

*.pidb

|

||||||

|

*.svclog

|

||||||

|

*.scc

|

||||||

|

|

||||||

|

# Chutzpah Test files

|

||||||

|

_Chutzpah*

|

||||||

|

|

||||||

|

# Visual C++ cache files

|

||||||

|

ipch/

|

||||||

|

*.aps

|

||||||

|

*.ncb

|

||||||

|

*.opendb

|

||||||

|

*.opensdf

|

||||||

|

*.sdf

|

||||||

|

*.cachefile

|

||||||

|

*.VC.db

|

||||||

|

*.VC.VC.opendb

|

||||||

|

|

||||||

|

# Visual Studio profiler

|

||||||

|

*.psess

|

||||||

|

*.vsp

|

||||||

|

*.vspx

|

||||||

|

*.sap

|

||||||

|

|

||||||

|

# Visual Studio Trace Files

|

||||||

|

*.e2e

|

||||||

|

|

||||||

|

# TFS 2012 Local Workspace

|

||||||

|

$tf/

|

||||||

|

|

||||||

|

# Guidance Automation Toolkit

|

||||||

|

*.gpState

|

||||||

|

|

||||||

|

# ReSharper is a .NET coding add-in

|

||||||

|

_ReSharper*/

|

||||||

|

*.[Rr]e[Ss]harper

|

||||||

|

*.DotSettings.user

|

||||||

|

|

||||||

|

# TeamCity is a build add-in

|

||||||

|

_TeamCity*

|

||||||

|

|

||||||

|

# DotCover is a Code Coverage Tool

|

||||||

|

*.dotCover

|

||||||

|

|

||||||

|

# AxoCover is a Code Coverage Tool

|

||||||

|

.axoCover/*

|

||||||

|

!.axoCover/settings.json

|

||||||

|

|

||||||

|

# Coverlet is a free, cross platform Code Coverage Tool

|

||||||

|

coverage*.json

|

||||||

|

coverage*.xml

|

||||||

|

coverage*.info

|

||||||

|

|

||||||

|

# Visual Studio code coverage results

|

||||||

|

*.coverage

|

||||||

|

*.coveragexml

|

||||||

|

|

||||||

|

# NCrunch

|

||||||

|

_NCrunch_*

|

||||||

|

.*crunch*.local.xml

|

||||||

|

nCrunchTemp_*

|

||||||

|

|

||||||

|

# MightyMoose

|

||||||

|

*.mm.*

|

||||||

|

AutoTest.Net/

|

||||||

|

|

||||||

|

# Web workbench (sass)

|

||||||

|

.sass-cache/

|

||||||

|

|

||||||

|

# Installshield output folder

|

||||||

|

[Ee]xpress/

|

||||||

|

|

||||||

|

# DocProject is a documentation generator add-in

|

||||||

|

DocProject/buildhelp/

|

||||||

|

DocProject/Help/*.HxT

|

||||||

|

DocProject/Help/*.HxC

|

||||||

|

DocProject/Help/*.hhc

|

||||||

|

DocProject/Help/*.hhk

|

||||||

|

DocProject/Help/*.hhp

|

||||||

|

DocProject/Help/Html2

|

||||||

|

DocProject/Help/html

|

||||||

|

|

||||||

|

# Click-Once directory

|

||||||

|

publish/

|

||||||

|

|

||||||

|

# Publish Web Output

|

||||||

|

*.[Pp]ublish.xml

|

||||||

|

*.azurePubxml

|

||||||

|

# Note: Comment the next line if you want to checkin your web deploy settings,

|

||||||

|

# but database connection strings (with potential passwords) will be unencrypted

|

||||||

|

*.pubxml

|

||||||

|

*.publishproj

|

||||||

|

|

||||||

|

# Microsoft Azure Web App publish settings. Comment the next line if you want to

|

||||||

|

# checkin your Azure Web App publish settings, but sensitive information contained

|

||||||

|

# in these scripts will be unencrypted

|

||||||

|

PublishScripts/

|

||||||

|

|

||||||

|

# NuGet Packages

|

||||||

|

*.nupkg

|

||||||

|

# NuGet Symbol Packages

|

||||||

|

*.snupkg

|

||||||

|

# The packages folder can be ignored because of Package Restore

|

||||||

|

**/[Pp]ackages/*

|

||||||

|

# except build/, which is used as an MSBuild target.

|

||||||

|

!**/[Pp]ackages/build/

|

||||||

|

# Uncomment if necessary however generally it will be regenerated when needed

|

||||||

|

#!**/[Pp]ackages/repositories.config

|

||||||

|

# NuGet v3's project.json files produces more ignorable files

|

||||||

|

*.nuget.props

|

||||||

|

*.nuget.targets

|

||||||

|

|

||||||

|

# Microsoft Azure Build Output

|

||||||

|

csx/

|

||||||

|

*.build.csdef

|

||||||

|

|

||||||

|

# Microsoft Azure Emulator

|

||||||

|

ecf/

|

||||||

|

rcf/

|

||||||

|

|

||||||

|

# Windows Store app package directories and files

|

||||||

|

AppPackages/

|

||||||

|

BundleArtifacts/

|

||||||

|

Package.StoreAssociation.xml

|

||||||

|

_pkginfo.txt

|

||||||

|

*.appx

|

||||||

|

*.appxbundle

|

||||||

|

*.appxupload

|

||||||

|

|

||||||

|

# Visual Studio cache files

|

||||||

|

# files ending in .cache can be ignored

|

||||||

|

*.[Cc]ache

|

||||||

|

# but keep track of directories ending in .cache

|

||||||

|

!?*.[Cc]ache/

|

||||||

|

|

||||||

|

# Others

|

||||||

|

ClientBin/

|

||||||

|

~$*

|

||||||

|

*~

|

||||||

|

*.dbmdl

|

||||||

|

*.dbproj.schemaview

|

||||||

|

*.jfm

|

||||||

|

*.pfx

|

||||||

|

*.publishsettings

|

||||||

|

orleans.codegen.cs

|

||||||

|

|

||||||

|

# Including strong name files can present a security risk

|

||||||

|

# (https://github.com/github/gitignore/pull/2483#issue-259490424)

|

||||||

|

#*.snk

|

||||||

|

|

||||||

|

# Since there are multiple workflows, uncomment next line to ignore bower_components

|

||||||

|

# (https://github.com/github/gitignore/pull/1529#issuecomment-104372622)

|

||||||

|

#bower_components/

|

||||||

|

|

||||||

|

# RIA/Silverlight projects

|

||||||

|

Generated_Code/

|

||||||

|

|

||||||

|

# Backup & report files from converting an old project file

|

||||||

|

# to a newer Visual Studio version. Backup files are not needed,

|

||||||

|

# because we have git ;-)

|

||||||

|

_UpgradeReport_Files/

|

||||||

|

Backup*/

|

||||||

|

UpgradeLog*.XML

|

||||||

|

UpgradeLog*.htm

|

||||||

|

ServiceFabricBackup/

|

||||||

|

*.rptproj.bak

|

||||||

|

|

||||||

|

# SQL Server files

|

||||||

|

*.mdf

|

||||||

|

*.ldf

|

||||||

|

*.ndf

|

||||||

|

|

||||||

|

# Business Intelligence projects

|

||||||

|

*.rdl.data

|

||||||

|

*.bim.layout

|

||||||

|

*.bim_*.settings

|

||||||

|

*.rptproj.rsuser

|

||||||

|

*- [Bb]ackup.rdl

|

||||||

|

*- [Bb]ackup ([0-9]).rdl

|

||||||

|

*- [Bb]ackup ([0-9][0-9]).rdl

|

||||||

|

|

||||||

|

# Microsoft Fakes

|

||||||

|

FakesAssemblies/

|

||||||

|

|

||||||

|

# GhostDoc plugin setting file

|

||||||

|

*.GhostDoc.xml

|

||||||

|

|

||||||

|

# Node.js Tools for Visual Studio

|

||||||

|

.ntvs_analysis.dat

|

||||||

|

node_modules/

|

||||||

|

|

||||||

|

# Visual Studio 6 build log

|

||||||

|

*.plg

|

||||||

|

|

||||||

|

# Visual Studio 6 workspace options file

|

||||||

|

*.opt

|

||||||

|

|

||||||

|

# Visual Studio 6 auto-generated workspace file (contains which files were open etc.)

|

||||||

|

*.vbw

|

||||||

|

|

||||||

|

# Visual Studio 6 auto-generated project file (contains which files were open etc.)

|

||||||

|

*.vbp

|

||||||

|

|

||||||

|

# Visual Studio 6 workspace and project file (working project files containing files to include in project)

|

||||||

|

*.dsw

|

||||||

|

*.dsp

|

||||||

|

|

||||||

|

# Visual Studio 6 technical files

|

||||||

|

*.ncb

|

||||||

|

*.aps

|

||||||

|

|

||||||

|

# Visual Studio LightSwitch build output

|

||||||

|

**/*.HTMLClient/GeneratedArtifacts

|

||||||

|

**/*.DesktopClient/GeneratedArtifacts

|

||||||

|

**/*.DesktopClient/ModelManifest.xml

|

||||||

|

**/*.Server/GeneratedArtifacts

|

||||||

|

**/*.Server/ModelManifest.xml

|

||||||

|

_Pvt_Extensions

|

||||||

|

|

||||||

|

# Paket dependency manager

|

||||||

|

.paket/paket.exe

|

||||||

|

paket-files/

|

||||||

|

|

||||||

|

# FAKE - F# Make

|

||||||

|

.fake/

|

||||||

|

|

||||||

|

# CodeRush personal settings

|

||||||

|

.cr/personal

|

||||||

|

|

||||||

|

# Python Tools for Visual Studio (PTVS)

|

||||||

|

__pycache__/

|

||||||

|

*.pyc

|

||||||

|

|

||||||

|

# Cake - Uncomment if you are using it

|

||||||

|

# tools/**

|

||||||

|

# !tools/packages.config

|

||||||

|

|

||||||

|